Foto: Pexels

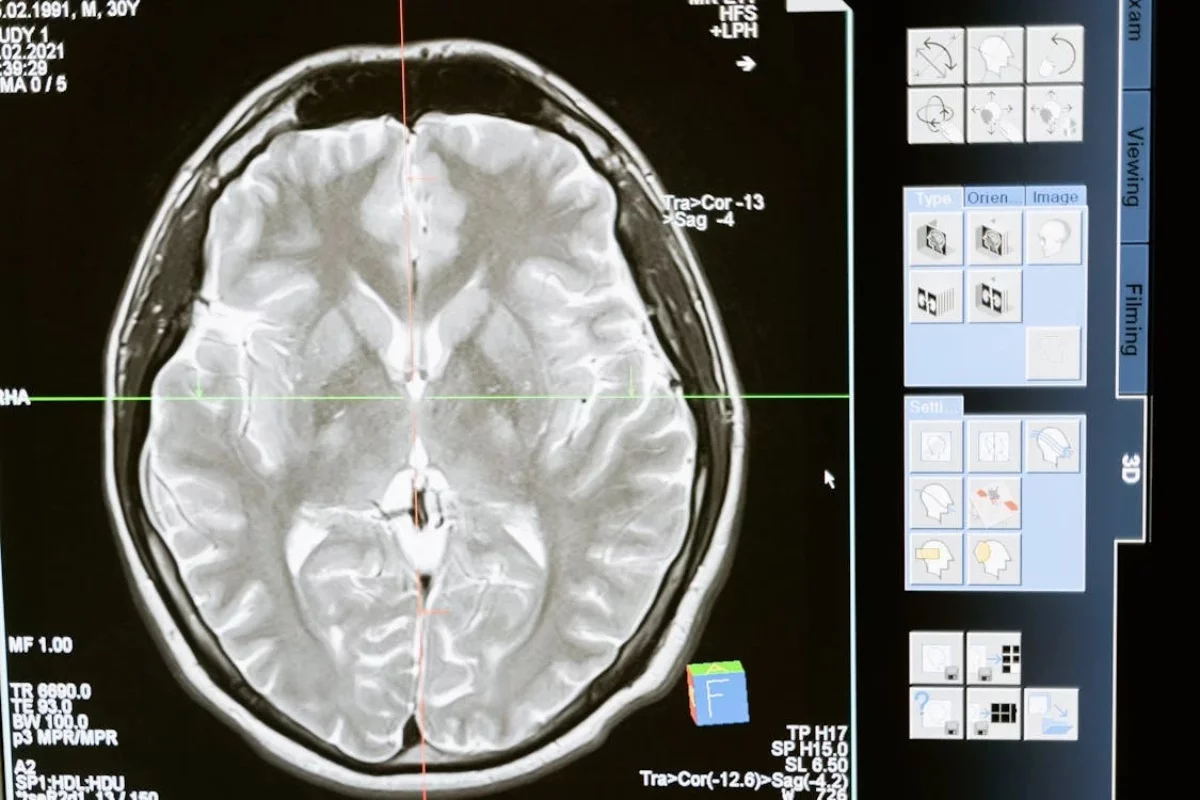

La inteligencia artificial ha demostrado tener una precisión impecable al momento de detectar datos sumamente minuciosos. En la medicina, la IA ha sido utilizada para realizar diagnósticos médicos, especialmente para analizar radiografías médicas.

Por ejemplo, el Hospital Houston Methodist emplea inteligencia artificial para proporcionar a los médicos y al personal herramientas predictivas en función de identificar mejor a los pacientes en riesgo y mejorar los resultados a largo plazo. Asimismo, los investigadores del Instituto Tecnológico de Massachusetts demostraron en 2022 que esta tecnología es capaz de realizar predicciones sobre la raza del paciente a partir de una radiografía. Sin embargo, el mismo equipo de investigadores descubrieron recientemente que los modelos de IA muestran una "brecha de equidad", lo cual conduce a resultados incorrectos para las mujeres, personas afrodescendientes y otros grupos.

El análisis realizado por la IA presenta discrepancias para diagnosticar con precisión imágenes de personas de diferentes razas o géneros. Esto se debe a que esta tecnología toma "atajos demográficos" para realizar el diagnóstico, un inconveniente que los investigadores han tenido en cuenta. Por tal motivo, reajustaron el modelo para quitar el sesgo. Al probarse con pacientes con los que el sistema fue entrenado funcionó, pero cuando se probó con pacientes que el sistema no conocía, la brecha de equidad volvió a aparecer.

Son modelos que son buenos para predecir enfermedades, pero durante el entrenamiento aprenden a predecir otras cosas que pueden no ser deseables", afirma Marzyeh Ghassemi, profesora asociada de ingeniería eléctrica y ciencias de la computación del MIT. En consecuencia, los investigadores se pusieron a investigar por qué el modelo no funciona tan bien con ciertos grupos.

A partir de las investigaciones, se descubrió que los modelos de IA utilizan categorizaciones demográficas como un atajo para hacer predicciones de enfermedades. Por lo tanto, los investigadores intentaron reducir la brecha, optimizando la "robustez de un subgrupo" y eliminando la información demográfica de las imágenes, utilizando estrategias de "confrontación grupal".

Los métodos de robustez de subgrupos obligan a los modelos a ser sensibles a las predicciones erróneas de un grupo específico, y los métodos de confrontación de grupos intentan eliminar por completo la información del grupo", afirma Ghassemi.

No obstante, los resultados solo fueron efectivos en los pacientes con los que el sistema fue entrenado. "Hemos descubierto que incluso los modelos de última generación que tienen un rendimiento óptimo en datos similares a los de sus conjuntos de entrenamiento no son óptimos en entornos nuevos", asegura la profesora.

Por lo tanto, estos sistemas, que son muy utilizados en varios hospitales, deberían ser evaluados en sus propios pacientes para asegurarse de que no se están arrojando resultados inexactos en ciertos grupos. Mientras tanto, el equipo del MIT sigue buscando la forma de optimizar esta inteligencia artificial para eliminar completamente el sesgo.

DESCARGA LA NOTA SÍGUENOS EN GOOGLE NEWS