Foto: Alan Cortés (NotiPress)

En los años más recientes, la medicina ha introducido nuevas herramientas como modelos de machine learning para mejorar la atención a los pacientes. Un nuevo estudio de Icahn School of Medicine and the University of Michigann reveló que los modelos de machine learning en el sector del cuidado de salud podría ser víctima de su propio éxito.

Publicado en la revista Annals of Internal Medicine, el estudio evalúo el impacto de la implementación de modelos predictivos en el desempeño posterior de esos y otros modelos. Los resultados mostraron cómo el uso de los modelos para ajustar la atención puede alterar los supuestos básicos sobre los que se "entrenaron" los modelos, generalmente para peor.

El estudio simuló un escenario crítico en dos importantes instituciones de salud, Mount Sinai Health System en Nueva York y Beth Israel Deaconess Medical Center en Boston. En total se analizaron 130 mil admisiones en estado delicado, descifrando tres escenarios clave.

Reentrenamiento del modelo después del uso inicial

Las prácticas actuales sugieren volver a entrenar los modelos para abordar la degradación del rendimiento con el tiempo. El reentrenamiento puede mejorar el desempeño al adaptarse a las condiciones cambiantes. El estudio Mount Sinai reveló que, paradójicamente, se puede conducir a una mayor degradación al alterar las relaciones aprendidas entre la presentación y resultado.

Creando un nuevo modelo después de que uno ya fue usado

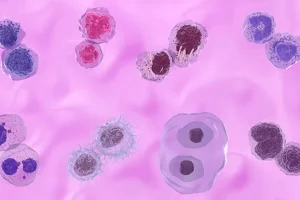

Seguir las predicciones de un modelo puede salvar a los pacientes de resultados adversos, como la sepsis. La muerte puede seguir a la sepsis y el modelo funciona eficazmente para prevenir ambas. Cualquier nuevo modelo desarrollado en el futuro para predecir la muerte, ahora estará sujeto a relaciones conflictivas como antes.

Como los investigadores no encontraron la relación exacta entre todos los posibles resultados, cualquier dato de los pacientes en la machine learning podría influir su cuidado de forma inapropiada para usarlo en el entrenamiento de otros modelos.

Uso concurrente de dos modelos predictivos

Si dos modelos hacen predicciones simultáneas, el uso de un conjunto de predicciones hace que el otro quede obsoleto. Las predicciones deben basarse en datos recién recopilados, lo que puede resultar costoso o poco práctico.

Akhil Vaid, primero autor del estudio, comentó que con este estudio buscaban explorar qué pasa cuando el aprendizaje automatizado es usado en los hospitales y permite influir en las decisiones de cuidado de los pacientes. Es decir, buscaron comprender las consecuencias más amplias cuando un paciente se salva de resultados adversos como daño renal o mortalidad.

Los resultados de los modelos predictivos no deben de verse como poco confiables. Por el contrario, se debe de reconocer que estas herramientas necesitan de mantenimiento regular, comprensión y contextualización. Descuidar su desempeño e impacto al monitorear puede dañar su efectividad, señalaron los investigadores.

DESCARGA LA NOTA SÍGUENOS EN GOOGLE NEWS